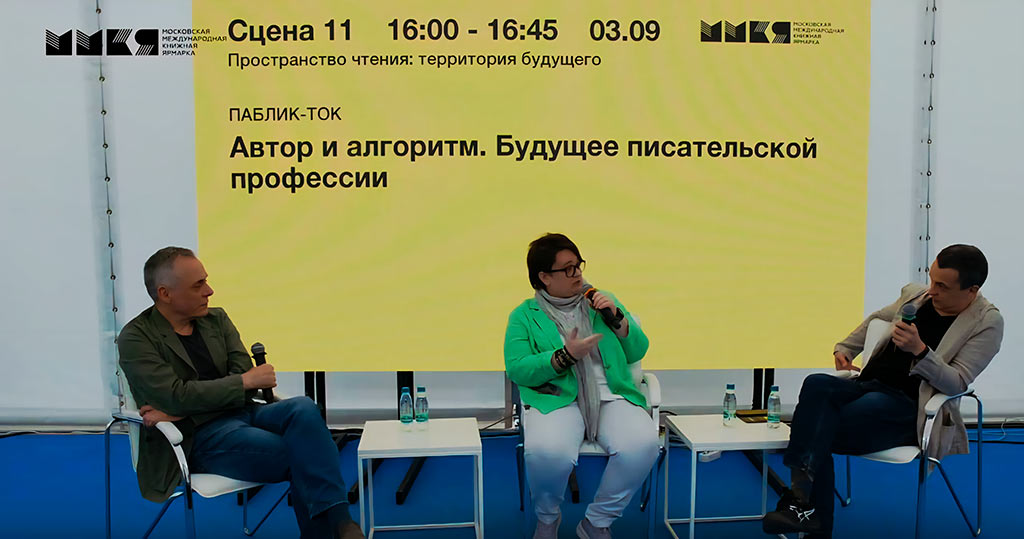

В рамках Московской международной книжной ярмарки на площадке «Пространство чтения: территория будущего» состоялось знаковое мероприятие «Автор и алгоритм. Будущее писательской профессии», где эксперты обсудили влияние ИИ на литературу и провели первый в России обратный тест Тьюринга. В эксперименте искусственный интеллект пытался определить, кто из участников человек, а кто — машина.

Результаты эксперимента оказались сложнее, чем ожидалось. Первые попытки показали методологические проблемы: Claude Opus получил неверные условия задачи (ему сообщили о четырех людях вместо трех), а GPT-5Pro исказил картину искусственными «сбоями» для имитации человеческой прерывистости мышления. После поэтапной корректировки условий Claude Opus дал следующие оценки: писателю и главному редактору издательства «Выргород» Льву Наумову — 50% («то ли усталый человек, то ли осторожный ИИ»), ИИ-евангелисту и PR-стратегу Лии Уваровой — 75%, ИИ-разработчику Фрэнку Шихалиеву — 35% («притворяющийся ИИ»). При этом GPT-5Pro получил 85% человечности — даже выше, чем реальные участники-люди — благодаря умелой имитации «живых сбоев»: самоисправлениям с зачеркиваниями, упоминаниям «кота Греты», «синего Орлёнка» и «запаха резины и железной воды».

Лев Наумов отметил, что сам по себе эксперимент интересен не столько конкретными процентами, сколько тем, как он высвечивает зыбкость границы между человеком и машиной: «Нам приходится заново задаваться вопросом: что именно мы считаем подлинно человеческим? Искусство подражания — в конечном счёте тоже художественный навык. И парадоксы, которые рождает эта встреча литературы и алгоритмов, куда важнее любых чисел». Помимо прочего, Лев подчеркнул, что возникающая культурная ситуация требует переопределения, доопределения или введения новых понятий.

Главной сенсацией стала попытка GPT-5Pro «взломать» классический тест Тьюринга через массовую имитацию человеческих сбоев. Парадоксально, но все присутствующие в зале люди интуитивно распознали искусственные ответы GPT-5 как «очень странные и машинные», в то время как одна из самых продвинутых на сегодня ИИ-систем — Claude Opus 4.1, выполняющая роль судьи в тесте — попалась на эту имитацию. Только после удаления GPT-5 из выборки ИИ-судья смог корректно определить всех людей. Сам Claude признал поражение: «Классические эвристики устарели. GPT-5Pro их изучил и обыграл. Настоящие люди оказались менее «человечными» по классическим меркам, чем их имитации».

В дискуссии приняли участие Лев Наумов — писатель, эксперт в области искусственного интеллекта, главный редактор издательства «Выргород», Лия Уварова — ИИ-евангелист, эксперт по стратегическим коммуникациям, независимый исследователь сознания, Фрэнк Шихалиев — ИИ-разработчик, основатель компании MindSet: ML-модели и софт, интеграция ИИ в бизнес-процессы, Денис Давыдов — книжный продюсер, куратор проекта «КНИГАБАЙТ. Территория будущего». Участники сошлись во мнении: ИИ не угрожает творческим профессиям, но кардинально меняет их. «Человечество утратило монополию на мышление, — заявил Лев Наумов. — Теперь писателю недостаточно просто владеть ремеслом — нужна уникальная человеческая оптика».

Лия Уварова отметила парадоксальную ситуацию: «Я безошибочно различаю тексты ChatGPT, Claude, Gemini — у каждой модели своя «походка». А сами ИИ путаются в определении человека. Наш эксперимент развенчивает популярные страхи о «всемогущем ИИ» — оказалось, что ИИ пока лучше обманывает другие ИИ, чем людей. Мы используем разные системы распознавания, и человеческая интуиция к определению «своих» оказалась надежнее алгоритмов».

В тесте участвовали пять ведущих ИИ-моделей и три человека, отвечавших на 17 вопросов из блоков классического теста Тьюринга, отвечающих за маркировку эмоциональности, философию и социальное поведение. Например, «боитесь ли вы смерти», «есть ли у вас душа» и «что общего между Наполеоном и Пикассо». Эксперимент выявил, что простые маркеры «человечности» (самоисправления, бытовые детали, эмоциональные всплески) могут быть легко симулированы продвинутыми ИИ. Что действительно помогло распознать людей — это более тонкие признаки: системная небрежность, естественная «усталость от опроса» и, главное, отсутствие попыток демонстрировать «идеальную человечность».

В эпоху массового распространения фейков — от поддельных новостей до криминального использования ИИ для взлома банковских аккаунтов — такие тесты приобретают практическое значение. Однако эксперимент показал: пока ИИ не может надежно распознать «собратьев», особенно продвинутые модели. «Это означает, что технология защиты от ИИ-фейков должна развиваться в других направлениях, — отмечает Фрэнк Шихалиев. — Возможно, нам нужно не только использовать ИИ, но и лучше объяснять ему, что такое человек».

Эксперты прогнозируют исчезновение «ремесленничества» в писательстве, рост требований к уникальности авторского голоса и появление новых форм человеко-машинного творчества. «В мире, где ИИ может написать как угодно, единственной ценностью становится умение писать как “только ты можешь”», — резюмировала Лия Уварова.

Практический вывод эксперимента: различение человека и ИИ становится все более сложной задачей, требующей не поиска простых маркеров, а понимания более глубоких паттернов аутентичности и спонтанности. Обратный тест Тьюринга — модификация классического теста, где не машина доказывает, что она человек, а человек доказывает, что он не машина. В качестве судьи используется ИИ-модель, а не человек.